Wenn Webseiten von Suchmaschinen wie Google indexiert wurde, dann werden sie auch in den Suchergebnislisten der Suchmaschinen (kurz SERPs) gelistet werden. Diese Indexierung ist daher wichtig für die Sichtbarkeit deiner Webseite. Was du machen musst, damit deine Webseite indexiert wird, dass findest du hier im Beitrag.

Aber manchmal möchte man auch bestimmte Webseiten nicht indexieren. Wie die „Nicht-Indexierung“ funktioniert, erfährst du ebenfalls hier im Beitrag.

Wie erlangt Google eigentlich Kenntnis von meiner Website?

Wie findet eine Suchmaschine wie Google eigentlich meine neue erstellte Website unter all den unzähligen Webseiten im www? Muss ich meine Website eventuell irgendwo anmelden, oder wird sie automatisch durch die Suchmaschinen gefunden und berücksichtigt?

Das ist eine absolut berechtigte Frage. Denn damit deine neu erstellte oder aktualisierte Website in den Search Engine Result Pages (SERPs) der Suchmaschinen auftaucht, müssen die Suchmaschinen natürlich auch erst einmal Kenntnis von der Website bekommen.

Suchmaschinen können diese Kenntnis von neuen Websites grundsätzlich auf zwei Wegen erlangen:

- die Website manuell bei der Suchmaschine zur Indexierung anmelden

- die Website von der Suchmaschine selbst finden und indexieren lassen

Hast du eine komplett neue Website gelauncht und hast du noch keine externen Links, die auf eine deiner Webseiten linken, dann kannst du jedoch unter Umständen lange darauf warten, dass Google & Co. deine Website findet und indexiert. Daher solltest du im Falle einer neuen Website, diese definitiv anmelden. Für die Anmeldung bei Google kannst du dafür die „Google Search Console“ nutzen.

Hast du dann damit deine Website angemeldet, erhält der Google-Bot (Bot ist die Kurzform von „Robot“) den Auftrag die entsprechende Website zu crawlen, d.h. die jeweiligen Inhalte der gesamten Website zu durchsuchen. Dazu verwendet Google sogar verschiedene Bots, je nach Art des Inhalts. Denn neben Texten werden auch Tonaufnahmen, Bilder und Videos gecrawlt und indexiert.

Damit spätere Änderungen an der Website auch erkannt werden, besucht der Bot die Website normalerweise in regelmäßigen Abständen, um den Inhalt zu überprüfen und eventuell den Index anzupassen.

Anhand von mittlerweile mehr als hundert verschiedener Faktoren mit unterschiedlicher Relevanz wird dann der gesamte Inhalt deiner Webseiten indexiert.

Was ist eine Indexierung / ein Index?

Im allgemeinen Sprachgebrauch versteht man unter einem Index (lat. für Verzeichnis, Register) ein geordnetes Verzeichnis, z.B. in einem Nachschlagewerk. In der Informatik steht ein Index für die Adressierung eines Elements in einem (mehrdimensionalen) Feld. Beide Definitionen geben einen guten Anhaltspunkt, was mit einem Index im Rahmen von Suchmaschinen gemeint ist.

Der Index ordnet somit die Relevanz einer Webseite hinsichtlich bestimmter Merkmale, hier von Suchbegriffen in ein Register ein.

Diesen Index erhalten die Webseiten, indem der Inhalt der Webseiten von den Suchmaschinen-Bots automatisiert durchsucht wird, man spricht dabei auch von crawlen. Die Inhalte der gecrawlten Webseiten werden dann durch einen bestimmten Algorithmus, der nur dem Betreiber der Suchmaschine bekannt ist, bewertet, sortiert und somit indexiert.

Dieser Index wird auch ständig von den Suchmaschinen überprüft und angepasst, ist somit nicht statisch.

Verstößt eine Webseite mehrmals oder stark gegen die Richtlinien der Suchmaschine, kann die Seite sogar aus dem Index herausgenommen werden und ist damit nicht mehr in den SERPs auffindbar. Dies gilt es somit unbedingt zu vermeiden, da wahrscheinlich auch bei Dir der Traffic durch Suchmaschinen der absolut größte Teil deines gesamten Traffics ausmachen wird.

Einzelne Webseiten von der Indexierung ausschließen

Wenn du einzelne Webseiten nicht in den Suchergebnissen auftauchen lassen möchtest, musst du dies der Suchmaschine explizit mitteilen, damit diese nicht mehr von der Suchmaschine indexiert wird.

Muss ich die Webseite nicht löschen, damit sie von den Suchmaschinen nicht mehr indexiert wird?

Grundsätzlich kannst du natürlich die Inhalte von einer einzelnen Webseite einfach entfernen, damit sie nicht mehr gefunden werden.

Dann meldet diese Webseite aber den Status „404 (Nicht gefunden)“ oder „410 (Entfernt)“ zurück. Allerdings ist sie dann auch komplett weg, für alle, und nicht nur für Suchmaschinen nicht mehr sichtbar.

Wenn du die Inhalte einer Webseite weiter aktiv stehen lassen willst und eben nur verhindern willst, dass sie von den Suchmaschinen gefunden und aufgelistet wird, dann musst du anders vorgehen.

Warum sollte ich denn manche Webseiten für Suchmaschinen „unsichtbar“ machen?

Wenn zum Beispiel die Webseite Inhalte beinhaltet, die nicht relevant für das Auffinden über Suchmaschinen sind, die aber trotzdem in deinem Webauftritt enthalten sein müssen /sollen.

Ein Beispiel für eine solche Anwendung sind z.B. das Impressum, die Datenschutzerklärung, AGBs und weitere Vertragswerke.

Solche Webseiten müssen nicht durch die Suchmaschinen in den SERPs als Suchergebnis gelistet werden. Das gilt insbesondere das Impressum. Nicht jeder Blogger möchte auch seine Privatadresse direkt bei der Suche nach seinem Namen auch seine privaten Kontaktdaten in den SERPs wiederfinden.

Zudem solltest du den wertvollen Linkjuice, der auf deine Website fließt, nicht auf „unwichtige“ Unterseiten lenken, damit deine eigentlichen Webseiten hinsichtlich SEO mehr Relevanz erhalten.

Wie kann ich einzelne Webseiten für Suchmaschinen ausschließen?

Wenn du die Sichtbarkeit dieser Webseite durch die Suchmaschinen unterbinden möchtest, dann gibt es dazu grundsätzlich vier Möglichkeiten:

- mit Hilfe des Tools „Google Search Console“ (Achtung nur temporär wirksam!)

Durch diese Methode wird die Webseite allerdings nur vorübergehend (ca. sechs Monate) und nur vom Index der Suchmaschine Google ausgeschlossen. - durch eine robots.txt Datei mit dem Befehl „disallow:“

Allerdings weist Google ausdrücklich darauf hin, dass man diese Art der Blockierung nicht nutzen sollte, wenn man die Seite nicht indexieren lassen will. Es kann hierbei nämlich dennoch passieren, dass deine Webseite trotzdem auf anderem Wege (z.B. Querverweise) in die Suchmaschinen SERPs gelangt. - per Meta-Tag „noindex“ im HTML-Code deiner Webseite

Dazu gibst du in den <head> Bereich der jeweiligen Webseite den Tag <meta name=“robots“ content=“noindex> ein. Soll die Webseite nicht indexiert werden aber die Suchmaschine dem Link folgen, so kannst du noch ein „follow“ ergänzen, dies sieht dann folgendermaßen aus: <meta name=“robots“ content=“noindex, follow“>.

Nutzt du diesen Tag, darfst du daneben allerdings keine robots.txt Datei nutzen, da dann das „noindex“ von der Suchmaschine nicht gelesen wird.

Das „interne“ Lesen und Ranken der betreffenden Webseite durch die Suchmaschinen wird durch das „noindex“ allerdings nicht unterdrückt. - durch einen Passwortschutz (per Login-Script mit PHP oder per .htaccess-Datei)

Welche der 4 Möglichkeiten soll ich nutzen?

Die beste Lösung um Webseiten wie das Impressum und Co. „unsichtbar“ für die Suchmaschinen zu machen ist, die Seite per Meta-Tag „noindex“ von der Indexierung auszuschließen.

Dies kannst du leicht mit vielen WordPress Tools durch Plugins wie RankMath, Yoast oder anderen SEO Tools oder auch bereits in manchen Themes direkt per „Schalter“ umsetzen, ohne den Tag manuell setzen zu müssen.

Willst du ganz sicher sein, dass eine bestimmte Webseite nicht indexiert wird und auch nicht durch die Suchmaschine gelesen werden soll, solltest du diese Webseiten am besten per Passwort durch Zugriffe schützen.

Tipps für eine gute Indexierung

Damit deine Website auch gut von den Suchmaschinen gefunden und gecrawlt werden kann, solltest du deine Website so einrichten, dass der Crawler es leicht hat durch die Struktur deiner Seite zu gehen, um zu jeder Webseite zu gelangen und sie dann gut indexieren zu können. Du solltest folglich die „Crawlability“ verbessern.

Dies kannst du erreichen, indem du folgende Dinge umsetzt:

- eine XML-Sitemap anlegen

- eine gute robots.txt definieren, z.B. um doppelte Seiten oder Archive von der Indexierung auszunehmen

- (viele) interne eingehende Links einbauen

- eine flache und logische Domainstruktur verwenden

- gute und übersichtliche interne Verlinkungen verwenden

Google Site Abfrage – Indexierte Webseiten abfragen

Möchtest du wissen, welche Webseiten deiner Website überhaupt der Suchmaschine Google bekannt sind?

Denn wenn die einzelnen Webseiten nicht im Suchmaschinenindex von Google gelistet sind, dann werden sie auch nicht in den Suchergebnissen, den SERPs, auftauchen.

Und das wäre schlecht, denn Google ist nun mal die Suchmaschine Nummer 1. Damit Google auch deine Webseiten in den Suchergebnissen berücksichtigen kann, muss Google erst einmal von deren Existenz Kenntnis haben um sie dann in den Suchmaschinenindex aufnehmen zu können.

Daher solltest du unbedingt überprüfen, ob alle deine Unterseiten auch indexiert sind.

Und wie machst du das? Ganz einfach, mit der Google Site-Abfrage.

Dazu musst du lediglich in das ganz normale Google Suchfeld statt des zu suchenden Begriffs den Begriff „site:“ gefolgt von deiner Domain angeben, also z.B. site:deinedomain.de.

Nach Drücken der Enter-Taste erhältst du alle Subdomains und Unterverzeichnisse, die bei Google indexiert sind. Durch das „hovern“ über die gefundenen Links erhältst du die genaue Adresse.

Man kann diese Suche auch noch durch Variationen der Suchbegriffe verfeinern, z.B. indem du deine Domain mit einem bestimmten Unterverzeichnis oder eine Subdomain eingibst und die Treffer überprüfst, siehe dazu weiter unten meine Auflistung der Suchoptionen.

Und auch noch wichtig zu wissen: Die Site-Abfrage funktioniert auch für deine Bilder.

Dazu gehst du genauso vor wie oben beschrieben, nur halt mit der Bildersuche-Funktion der Suchmaschine. Je mehr Bilder von deiner Website bei Google indexiert sind, desto höher ist auch die Chance, dass du zusätzliche Seitenbesucher für deinen Blog durch die Google Bildersuche erhältst. Daher solltest du unbedingt auch die Bilder mit guten Bildunterschriften inklusive Keywords versehen, damit deine Bilder auch einen guten Index erhalten.

Übersicht über die möglichen Verfeinerungen der Site-Abfrage

Um deine Site-Abfrage zu verfeinern, kannst du mehrere Befehle nutzen:

| site:deinedomain.de | Site Abfrage aller Webseiten und Subdomains unter dieser Domain |

| site:www.deinedomain.de | Site Abfrage aller Webseiten deiner Domain, die unter www. geführt werden |

| site:deinedomain.de -Unterverzeichnis | Das Minuszeichen hilft dabei bestimmte Subdomains oder Unterverzeichnisse aus der Site Abfrage auszuklammern |

| site:deinedomain.de/Unterverzeichnis | Site Abfrage eines bestimmten Unterverzeichnisses |

| site:deinedomain.de Suchbegriff | Site Abfrage zu einem bestimmten Suchbegriff (Keyword) der in allen Webseiten, in Überschriften, Texten oder Domainnamen, der Domain enthalten ist |

| site:deinedomain.de inurl:Suchbegriff | Site Abfrage zu allen Domains deiner Website, die den eingegebenen Suchbegriff enthalten |

| site:deinedomain.de intitle:Suchbegriff | Site Abfrage zu allen Titeln in deiner Website, die den eingegebenen Suchbegriff beinhalten |

| site:deinedomain.de intext:Suchbegriff | Site Abfrage zu allen Webseiten, die im Text den eingegebenen Suchbegriff enthalten |

| site:deinedomain.de filetype:doc | Site Abfrage zu allen Webseiten deiner Domain, die einen bestimmten Dateityp enthalten, z.B. doc, xls, pdf, zip, etc. |

Muss ich die Google Site-Abfrage nur nach dem Launch der Website machen oder auch später noch?

Du solltest die Site-Abfrage immer wieder mal nutzen, um abzugleichen, ob die Anzahl deiner Webseiten auch mit der Anzahl der indexierten Webseiten der Site-Abfrage übereinstimmt.

Ist dies nicht der Fall, ist dies ein Hinweis, dass ein Problem besteht.

Sind z.B. zu wenige Webseiten im Index, kann das Problem z.B. durch Duplicate Content entstanden sein.

Sind zu viele Webseiten im Index, kann das Problem sein, dass dort Domains mit Parametern, dynamische URLs oder URLs mit Paginierungsangaben indexiert sind.

Das könnte dich auch interessieren:

- Was ist SEO? Suchmaschinenoptimierung verständlich erklärt! Genial für Anfänger!Du möchtest erfahren was genau hinter SEO, bzw. Suchmaschinenoptimierung steckt? Wie sich SEO von SEA abgrenzt? Und welche SEO-Kategorien es gibt? Sehr gut, dann solltest du diesen Artikel lesen. Denn … Weiterlesen …

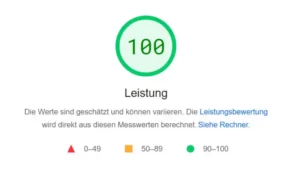

- PageSpeed verbessern – durch diese 20 Maßnahmen optimierst du die Ladezeit!Wie schnell deine Webseiten laden, ist ein immens wichtiger Faktor für die User Experience und das Ranking deiner Website. Denn die Ladezeit, auch Pagespeed genannt, ist ein direkter und gewichtiger … Weiterlesen …

- Sitemaps – gut für Crawler und SeitenbesucherJeder der im Internet surft hat wahrscheinlich schon einmal den Begriff „Sitemap“ gelesen. Meist ist er in der Fußzeile (Footer) einer Webseite zu sehen. Doch was genau sind eigentlich diese … Weiterlesen …